Hypothèse et méthodologie : un corpus fragmenté, une collaboration accrue

Nous l’avons dit, la façon d’envisager le document d’archives et la manière dont on le donne à lire ont une incidence directe sur les analyses qui en sont faites. Les choix éditoriaux constituent autant le résultat d’une démarche analytique qu’ils précèdent cette démarche et la conditionnent (Wien, 2007). À l’heure des humanités numériques, comment éviter que le choix des documents et la manière de les diffuser limitent et biaisent les recherches ultérieures ? Nous croyons que la collaboration entre chercheurs et partenaires, le partage des données primaires de recherche et le décloisonnement des corpus individuels, disciplinaires et institutionnels permettront d’optimiser les données et les métadonnées et de bonifier les résultats de recherche de l’ensemble de l’équipe. Ceci suppose l’établissement de protocoles de traitement de la documentation pour assurer la compatibilité des données générées et leur accessibilité à toute la communauté des chercheurs et, à plus long terme, au public. Il est aussi essentiel de travailler de concert avec les partenaires pour s’assurer que le projet réponde à leurs besoins de mise en valeur et s’arriment à leur calendrier de diffusion.

Une technologie de pointe : l’association image-texte et métadonnées

Pour prendre en compte les caractéristiques textuelles et structurelles des documents, il est important de conserver l’association entre la transcription d’un document et son image. Pour ce faire, le projet Nouvelle-France numérique utilise le logiciel libre Transkribus, développé par la coopérative européenne READ (Recognition and Enrichment of Archival Documents), dont l’UQAR est le premier membre institutionnel nord-américain. Ce logiciel permet d’identifier, dans la transcription d’un document, les coordonnées pixel où apparaît chaque ligne de texte dans l’image qui leur est associée. Grâce à des algorithmes d’intelligence artificielle et à des modèles de reconnaissance de l’écriture manuscrite (HTR ou Handwritten Text Recognition) entraînés à partir d’un type d’écriture et d’une langue donnés, Transkribus effectue automatiquement la transcription des manuscrits numérisés. Dans le cadre d’un partenariat établi en février 2018 entre l’Université du Québec à Rimouski (UQAR) et la coopérative READ, les fondateurs du projet, Catherine Broué et Maxime Gohier, ont déjà créé le premier modèle Transkribus de reconnaissance du manuscrit adapté au français moderne (17e et 18e siècles), à partir d’un corpus d’environ 1000 pages. Ce modèle est désormais disponible pour l’ensemble des utilisateurs (41 000 personnes à ce jour!) de Transkribus partout dans le monde. Encore en développement, il atteint déjà des taux d’efficacité de 90 à 96 % (selon les graphies). Actuellement, les serveurs de la coopérative READ qui effectuent le traitement des données pour le logiciel Transkribus sont en mesure de traiter jusqu’à 200 000 pages numérisées par jour (versement d’images, reconnaissance spatiale des zones de texte et transcription automatisée), ce qui couvre largement nos besoins. De plus, divers modèles adaptés à des graphies précises ont été développés à partir du modèle principal, avec des résultats étonnants.

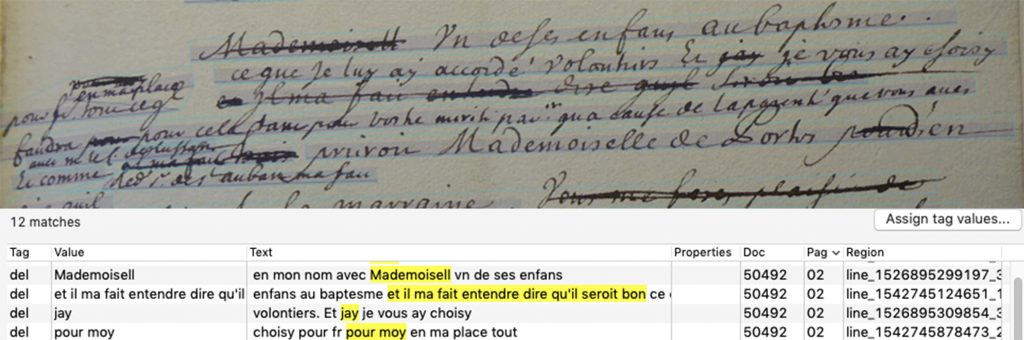

Outre la reconnaissance automatique des manuscrits, Transkribus permet d’ajouter aux transcriptions des métadonnées dont les chercheurs peuvent ou non tenir compte, selon le type d’analyse qu’ils souhaitent effectuer. Ces métadonnées concernent aussi bien la description matérielle des documents (données archivistiques, marques de classement ou de possession) que le processus d’écriture (abréviations, ratures, ajouts, notes, déplacements, graphies ou encres distinctes), le « genre » des textes (structure globale et divisions internes, présence ou absence de figures) et des éléments textuels (dates, lieux, onomastique, ethnonymes, toponymes, langues, institutions, fonctions sociales). Une fois intégrés systématiquement aux transcriptions, ces renseignements peuvent enrichir la recherche textuelle. Par exemple, associer une recherche plein-texte (Solr) à une recherche par balise (tags) permet de faire ressortir un ou des éléments textuels supprimés sur la copie, alors que ces éléments n’apparaîtraient pas si l’outil de recherche ne prenait en compte que la dernière formule retenue par le copiste.

L’ajout des métadonnées aux textes se fait, dans Transkribus, en suivant la nomenclature de la Text Encoding Initiative (TEI), standard de balisage de plus en plus répandu en humanités numériques. Développé en continu depuis les années 1980, le protocole TEI (TEI-Consortium, 2017) utilise un format universel d’encodage de données (le langage xml) pouvant être lu par n’importe quel ordinateur. Il permet le traitement de textes de tous genres et de toutes langues (Burnard, 2015). Jusqu’à tout récemment, le balisage TEI supposait un processus long et laborieux, étant donné qu’il devait être effectué manuellement une balise à la fois au fil du texte, ce qui limitait là encore la capacité de traitement. Or, Transkribus comprend un module intégré de balises XML-TEI pré-codées (lequel peut être adapté pour inclure n’importe quelle balise TEI), si bien que deux clics de souris suffisent pour baliser un élément particulier du texte et ajouter des métadonnées jugées pertinentes.

Dans le cadre du projet Nouvelle-France numérique, il est prévu d’utiliser Transkribus pour perfectionner nos modèles de reconnaissance pour différents types de sources et pour des graphies précises. Ainsi, un échantillon d’environ 5000 pages de texte fera l’objet d’une transcription minutieuse (« ground truth ») contrevérifiée par trois transcripteurs différents, afin de réduire au maximum les risques d’erreur. Cet échantillon servira ensuite à entraîner des modèles de reconnaissance qui devraient atteindre des taux d’erreur inférieurs à 4 % des caractères. Ces modèles serviront à transcrire automatiquement un corpus d’environ 120 000 pages de manuscrits provenant des différents fonds partagés par les centres d’archives partenaires. Les chercheurs qui souhaitent faire une analyse textuelle fine de certaines parties du corpus ainsi généré sont appelés à contribuer au projet en corrigeant les documents qui les intéressent. Ces participations individuelles, si modestes qu’elles soient, contribueront à la fois au perfectionnement des modèles de reconnaissance de caractères et à la constitution d’une vaste base de données textuelles et relationnelles, qui sera disponible à l’ensemble des collaborateurs. Par ailleurs, les transcriptions réalisées à partir des documents fournis par les centres d’archives partenaires leur seront remises pour qu’ils les mettent en valeur dans leurs bases de données.

En ce qui concerne l’ajout des métadonnées TEI, le projet repose aussi sur l’utilisation de Transkribus pour effectuer un balisage raffiné du même échantillon de 5000 pages. Grâce à cet échantillon, des outils informatiques seront développés pour étendre les balises codées à l’ensemble des transcriptions produites par les différents chercheurs-collaborateurs, de même qu’à appliquer à l’ensemble des corpus toute nouvelle balise qui serait ajoutée par la suite. À cet égard, un prototype de logiciel a été déjà développé par en partenariat avec la firme DWD inc. de Montréal et son implantation sera réalisée au cours des trois prochaines années. Une fois ce développement terminé, il restera à intervenir de façon plus minutieuse sur les documents posant des problèmes spécifiques de balisage : disposition particulière du texte sur les pages, documents abimés ou de lecture plus difficile, ratures et réécritures, problème d’identification d’auteur. Outre le balisage, l’outil devrait aussi permettre d’accélérer la correction des transcriptions en repérant automatiquement les apax (termes qui n’apparaissent qu’une seule fois dans un corpus), qui sont les plus susceptibles de comporter des erreurs.

Analyses

À partir des constats déjà faits sur de petits corpus grâce à des moyens traditionnels (analyse de discours, analyse matérielle, critique historique, transcriptions manuelles et non partagées), nous déterminerons s’il est possible de valider, peaufiner ou invalider les résultats existants en diversifiant et en élargissant les corpus. L’analyse systématique de la correspondance de différents acteurs administratifs, de greffes de notaires ou d’écrits de missionnaires, par exemple, permettra d’établir des corrélations statistiques (récurrences structurelles ; segments de texte, locutions ou thèmes se répétant d’un document à un autre ; figures stylistiques, vocabulaire ou groupes de mots récurrents) ou des oppositions (passages modifiés ou coupés ; survalorisation ou dévalorisation de protagonistes, de lieux ou d’événements ; modification du vocabulaire) permettant de mieux comprendre l’origine et l’historicité des documents (Wien, 2018; Lebart, Pincemin et Poudat, 2019). Par exemple, en croisant des grammaires ou des glossaires de langues autochtones avec des récits viatiques et des comptes rendus de démarches diplomatiques franco-autochtones, il serait possible de retracer tous les passages écrits dans des langues précises (abénakis, innu, mohawk…) et d’identifier des formules linguistiques et stylistiques récurrentes ou singulières selon les documents, pour ainsi faire émerger des acteurs ou des étapes de circulation de l’information entre ordres religieux, administration coloniale, partenaires commerciaux ou conseillers royaux.